알리바바 그룹의 지능형 컴퓨팅 연구소에서 선보인 EMO AI는 단순한 이미지 변환을 넘어, 사진과 오디오 파일을 결합하여 말하고 노래하는 인물의 영상을 생성하는 혁신적인 기술입니다. 이 글에서는 EMO AI의 작동 원리부터 사용 방법, 놀라운 영상 샘플들까지 EMO AI의 모든 것을 소개합니다.

EMO의 작동 원리

EMO AI 모델은 사용자가 제공한 사진과 오디오를 기반으로 인물이 말하거나 노래하는 영상을 생성합니다.

이 과정에서 생성된 인물의 표정은 매우 풍부하며, 말하는 내용과 입 모양이 자연스러운 일치를 보입니다.

EMO AI는 오디오 입력과 참조 이미지를 기반으로 한 인물의 얼굴 이미지를 생성하는 AI 기반 프레임워크입니다.

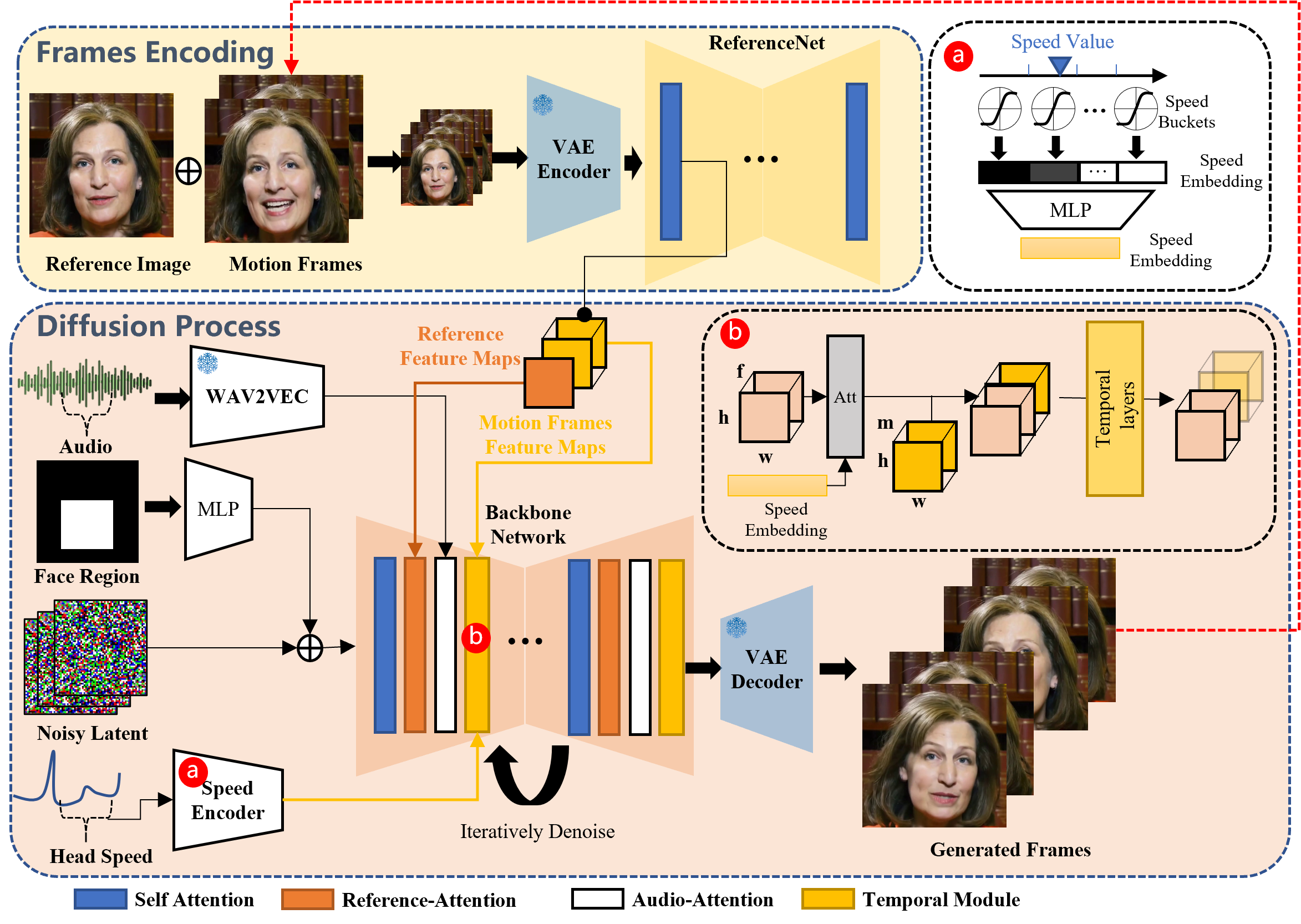

Frames Encoding

- ReferenceNet 사용: 참조 이미지와 모션 프레임에서 특징을 추출하여 중요 정보를 인코딩하고 저장합니다.

Diffusion Process

- 오디오 데이터 처리: 사전 훈련된 오디오 인코더를 사용하여 오디오 임베딩을 생성합니다.

- 얼굴 영역 마스크와 다중 프레임 노이즈 통합: 생성될 얼굴 이미지의 형태와 특징을 제어합니다.

Attention 메커니즘

- Reference-Attention: 참조 이미지의 특징을 기반으로 생성된 이미지가 해당 인물과 일치하도록 합니다.

- Audio-Attention: 오디오 데이터와 이미지 사이의 동기화를 담당합니다.

EMO AI 사용하기

EMO 모델은 현재 깃허브를 통해 공개되었으며, 모델의 개선과 안정성 확보를 위한 추가적인 테스트가 필요합니다.

관심 있는 이용자들은 깃허브의 공식 문서를 통해 모델에 대한 더 많은 정보를 얻을 수 있습니다.

EMO AI 의 놀라운 영상 샘플들

EMO를 통해 생성된 영상 샘플입니다.

오드리 햅번의 사진과 Ed Sheeran의 “Perfect”를 결합한 영상

모나리자와 Miley Cyrus의 “Flowers”를 합친 영상

과거의 인물 사진과 오디오의 결합

빠른 언어 구사 능력

다양한 AI 모델의 공개

알리바바 그룹은 EMO 외에도 Animate Anyone 모델과 같이 이미지 속 인물이나 캐릭터를 춤추게 하는 기술을 개발하고 있습니다.

더 많은 EMO 영상을 원하시나요?

EMO로 생성된 더 많은 영상을 보고 싶다면, 알리바바 그룹의 지능형 컴퓨팅 연구소 웹사이트를 확인해보세요. 이들 페이지에서는 EMO 모델을 통해 만들어진 다양하고 매혹적인 영상 샘플들을 제공합니다.